Pour intégrer efficacement la transparence dans les systèmes d’IA, il est essentiel d’adopter une approche fondée sur l’ensemble de leur cycle de vie.

« La notion de cycle de vie, quel que soit le système considéré, décrit l’ensemble des phases de l’existence de ce système depuis l’idée jusqu’à la fin de vie » (Prioux, 2023)

L’analyse du cycle de vie est une méthode d’évaluation globale qui prend en compte les impacts environnementaux, économiques et sociaux d’un système, de sa conception jusqu’à son démantèlement.

Ce concept est à la fois universel et transversal, il s’applique à tout type de produit, service, système ou projet. Il repose sur une logique de continuité et de responsabilité, indispensable pour évaluer les impacts négatifs et positifs du système d’IA, et pour valider les éléments de conformité tout au long de son développement. L’analyse du cycle de vie permet de couvrir toutes les étapes : la fabrication, la mise en service, l’utilisation, le recyclage ou la fin de vie du produit (Prioux, 2024, p.43).

Son objectif est clair : favoriser des décisions éclairées, en intégrant les effets à long terme. Cette approche est résolument conséquentialiste car elle vous invite à anticiper les effets de certains choix.

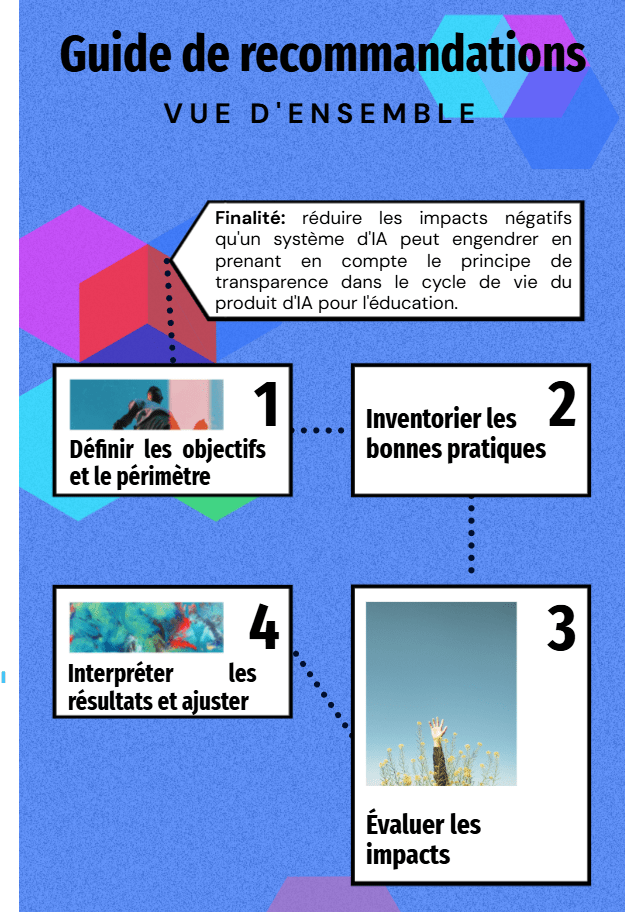

C’est pourquoi ce guide de recommandations s’appuie sur cette approche : il vous propose une structure adaptable à une grande diversité d’objectifs système et de méthodologie de gestion de projet, tout en vous accompagnant dans l’intégration progressive du principe de transparence à chaque étape du cycle de vie :

Objectif du guide

Ce guide a pour ambition de vous accompagner dans l’intégration du principe de transparence tout au long du cycle de vie de votre système d’IA, en cohérence avec la réglementation européenne (AI Act, 2024).

En appliquant ces recommandations à chaque étape de votre projet, vous serez en mesure de mieux anticiper les risques, de renforcer la confiance des utilisateurs et, surtout, de réduire les impacts négatifs que votre produit d’IA éducatif pourrait engendrer.

« Fournir une base de données et d’informations rigoureuse pour la compréhension technique afin d’aider la prise de décision tout au long du cycle de vie » [ISO/IEC/IEEE 15288 :2015,2015].

Ce guide s’appuie sur cette approche pour vous aider à anticiper les effets des choix de conception sur la confiance future des utilisateurs. Il propose une vision systémique de la transparence, fondée sur la définition des systèmes d’IA donnée par l’AI Act :

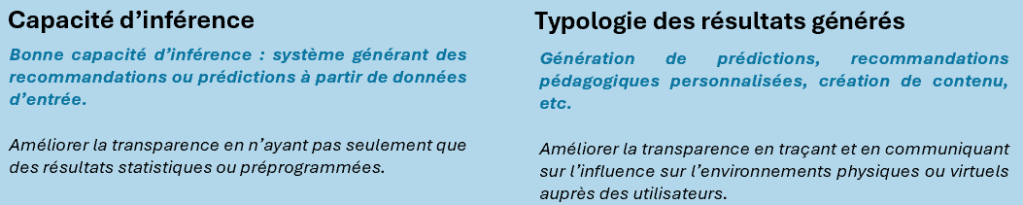

« système automatisé qui est conçu pour fonctionner à différents niveaux d’autonomie et peut faire preuve d’une capacité d’adaptation après son déploiement, et qui, pour des objectifs explicites ou implicites, déduit, à partir des entrées qu’il reçoit, la manière de générer des sorties telles que des prédictions, du contenu, des recommandations ou des décisions qui peuvent influencer les environnements physiques ou virtuels » (IA Act, Art 3)

Au travers de cette définition nous avons cartographier huit éléments permettant d’aider à l’analyse d’impact (vous pouvez retrouver le tableau de bord intégral en bas de page) :

Plutôt que d’imposer un cadre rigide, il vous offre la flexibilité de sélectionner les recommandations les plus pertinentes selon les enjeux spécifiques de votre projet, tout en vous guidant à travers les quatre grandes étapes de la conception.

Définir les objectifs et le périmètre

Avant toute chose, il est essentiel de savoir ce que vous voulez analyser et jusqu’où s’étend votre champ d’action. Cette étape inclut également l’analyse du besoin du commanditaire, dans laquelle vous devez justifier l’intégration du principe de transparence. Cette démarche contribue à poser les bases d’un projet aligné avec les exigences réglementaires et éthiques :

La commission européenne, à travers l’AI Act, a établi une classification des systèmes d’IA selon leur niveau de risque. En particulier, les systèmes utilisés dans le domaine éducatif peuvent être considérés comme à haut risque, en fonction de leurs objectifs.

L’AI Act impose alors des obligations renforcées, que nous avons intégrées dans ce guide sous forme d’exigence. Voici un récapitulatif des cas concernés :

Systèmes d’IA à haut risque dans l’éducation

(Chapitre III et Récital 56, AI Act)

| Objectifs du système | Exemples d’usage |

| « les systèmes d’IA destinés à être utilisés pour déterminer l’accès, l’admission ou l’affectation de personnes physiques à des établissements d’enseignement et de formation professionnelle à tous les niveaux » | Optimiser les processus d’admission éducative en améliorant la gestion des candidatures et en facilitant les processus de sélection. |

| Automatiser l’affectation des étudiants à des établissements ou programmes éducatifs, en fonction de critères prédéfinis et des besoins pédagogiques. | |

| « les systèmes d’IA destinés à être utilisés pour évaluer les résultats de l’apprentissage, y compris lorsque ces résultats sont utilisés pour orienter le processus d’apprentissage des personnes physiques dans les établissements d’enseignement et de formation professionnelle à tous les niveaux » | Évaluer les résultats d’apprentissage grâce à des algorithmes capables d’analyser les performances et d’adapter les recommandations pédagogiques. |

| « les systèmes d’IA destinés à être utilisés pour évaluer le niveau d’éducation approprié qu’une personne recevra ou pourra atteindre, dans le cadre ou au sein des établissements d’enseignement et de formation professionnelle à tous les niveaux » | Déterminer le niveau d’éducation approprié pour chaque apprenant, en tenant compte de ses compétences et de son évolution académique. |

| Influencer et personnaliser les parcours éducatifs en ajustant les programmes et les ressources pédagogiques selon les données d’apprentissage individuelles. | |

| « les systèmes d’IA destinés à être utilisés pour surveiller et détecter les comportements interdits des étudiants lors des tests dans le cadre ou au sein des établissements d’enseignement et de formation professionnelle à tous les niveaux. » | Surveiller et détecter les comportements interdits lors des évaluations afin de garantir l’intégrité académique et prévenir les fraudes. |

Faire un inventaire du cycle de vie

Cette étape consiste à recueillir l’ensemble des données relatives à votre système d’IA, en distinguant :

- Les données directes, que votre institution contrôle (ex.: données internes, choix de conception);

- Les données indirectes, issues de vos fournisseurs ou partenaires technologiques

L’objectif est de permettre une compréhension systémique du fonctionnement du système, afin de faciliter l’évaluation des impacts positifs et négatifs, ainsi que l’identification des risques associés.

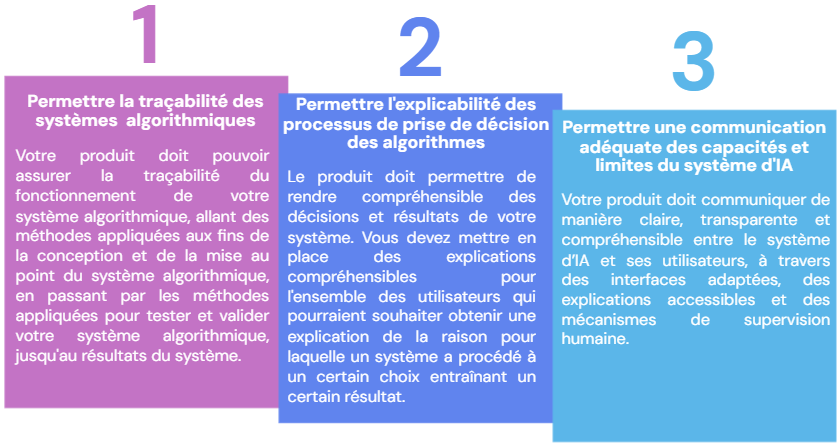

Cette transparence systémique repose sur trois piliers essentiels pour une conception éthique :

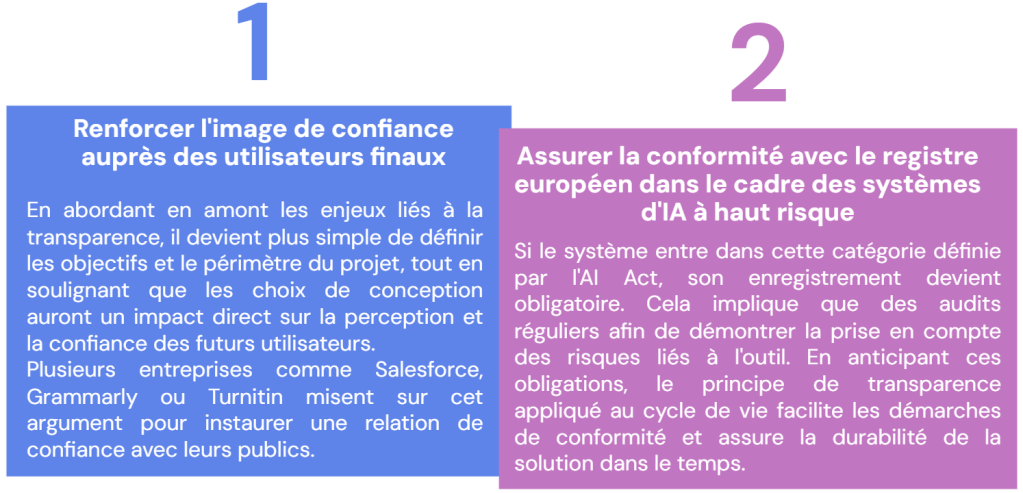

D’un côté, si votre objectif principal est de renforcer la confiance des utilisateurs, votre inventaire devra mettre l’accent sur les éléments de mise en conformité qui influencent directement la perception du système.

De l’autre, si votre priorité est de répondre aux exigences réglementaires, votre inventaire devra cibler les obligations légales qui garantissent la durabilité et la responsabilité du système.

Toutefois, vous pouvez garder en tête que ces deux objectifs sont complémentaires et étroitement liés dans nos recommandations :

Evaluation des impacts

Une fois les données collectées, il est essentiel de les classer selon leurs effets potentiels, en identifiant les impacts positifs et négatifs que le système d’IA pourrait générer.

Exemples d’impacts positifs :

- Une interface claire permettra une confiance renforcée.

- Une explication des corrections favorise un apprentissage autonome.

- Un tableau de bord des données apportera un sentiment de contrôle.

Exemples d’impacts négatifs :

- Une politique floue peut susciter de la méfiance.

- Des suggestions opaques peuvent entraîner une dépendance ou un rejet.

- L’utilisation des données sans consentement explicite peut nuire à la réputation de l’institution.

Interprétation des résultats

L’analyse des résultats permet de tirer des enseignements concrets et de proposer des améliorations ciblées.

Par exemple, si votre système présente un fort degré d’automatisation, il sera pertinent de renforcer la clarté de l’interface. Une interface transparente favorise un contrôle éthique et limite le risque de perte de confiance, notamment lorsque l’implication humaine dans la supervision est faible.

Ce manque de confiance peut être accentué si les données personnelles sont utilisées sans consentement explicite.

Exemple qui m’a inspiré

L’entreprise Grammarly a intégré un bouton activable/désactivable permettant à l’utilisateur de choisir comment ses données sont utilisées pour personnaliser les suggestions du système. Cette fonctionnalité incarne une démarche transparente et centrée sur l’utilisateur, renforçant la confiance dans l’outil :

Tableau de bord pour guider l’analyse

Vous pouvez vous référer au tableau de bord ci-dessous, qui vise à prendre en compte les risques selon les huit éléments caractéristiques des système d’IA définis par l’AI Act :