Cet outil peut être utiliser tout au long du cycle de vie de votre système d’IA éducatif. Il vous aide à garantir la conformité réglementaire de votre déploiement, depuis la définition des objectifs initiaux jusqu’à l’évaluation de sa qualité globale.

Vous pouvez l’intégrer comme étape clé de validation, afin de vous assurer que toutes les composantes de votre projet ont été vérifiées et documentées avant de passer à un audit externe.

Pour comprendre comment utiliser le guide de recommandations, nous pouvez vous appuyer sur le cycle en V adapté de [AFIS, 2004], repris dans la thèse de Prioux (2023, p.20).

Ce modèle illustre les différentes phases du développement d’un système, de l’analyse du besoin à la validation finale.

L’analyse du besoin et validation

Cette phase vise à définir les finalités du système en lien avec les besoins initiaux identifiés, tout en anticipant les critères de validation. Elle permet également d’initier une réflexion sur les conséquences potentielles sur les droits fondamentaux, afin de nourrir la transparence future.

La prise en compte de la transparence peut se faire en questionnant la dimension systémique du futur système d’IA.

Voici quelques éléments à considérer pour positionner vos objectifs et votre périmètre :

- Niveau d’autonomisation du système : va d’un système fondé sur une machine automatisée jusqu’à un système fondé sur la connaissance.

- Degré d’autonomie du système : varie entre un système capable de générer des résultats sans intervention humaine constante, à un système nécessitant une supervision humaine régulière voire continue pour fonctionner correctement.

- Capacité d’auto-apprentissage : s’étand d’un système doté de facultés d’apprentissage et d’évaluation post déploiement (Machine Learning adaptatif) jusqu’à un système strictement figé dans les règles imposées par son concepteur.

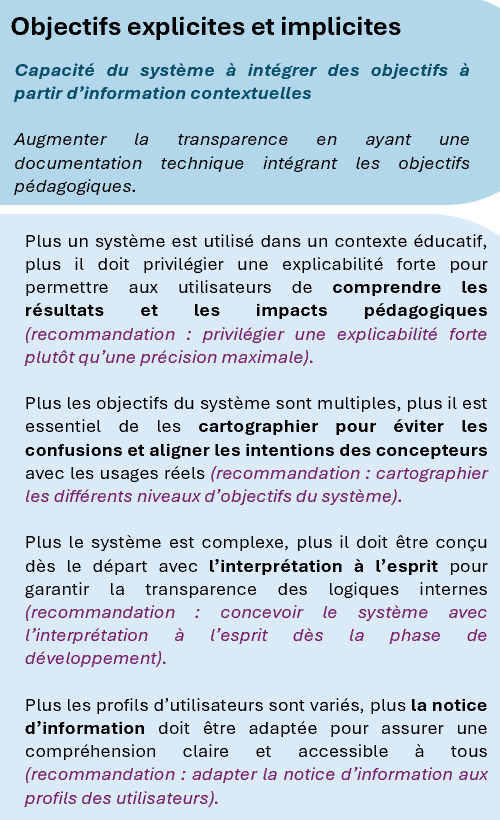

- Clarté des objectifs (explicites ou implicites) du système : englobe des systèmes programmés avec des objectifs explicites et compréhensibles, jusqu’à des systèmes dont les objectifs sont implicites, inférer par le comportement ou l’environnement, voir totalement absents ou ambigus dans un contexte éducatif.

- Capacité d’inférence : va de systèmes capables de tirer des conclusions ou de générer des contenus à partir de leurs données d’entraînement, à ceux incapables de produire des prédictions, des recommandations ou des suggestions interprétables.

- Typologie des résultats générés pouvant influencer les environnements physiques ou virtuels : couvre les systèmes générant plusieurs types de résultats tels que : prédictions, recommandations, contenus, décisions automatisées ; jusqu’aux systèmes n’ayant aucune capacité générative.

- Interaction avec l’environnement : va d’une influence active sur les environnements physique (objet, infrastructure) et virtuels (numérique ou flux de données, plateformes), à une influence minimale ou uniquement passive.

- Niveau de classification du système d’IA (selon l’AI Act) : varie du risque minimal, en passant par un risque élevé dans des domaines sensibles comme l’éducation, jusqu’à un niveau de risque considéré comme inacceptable et donc prohibé.

Ce dernier élément nécessite de connaître la classification des systèmes d’IA par niveau de risque (AI Act, Art 6), ainsi que se référer aux objectifs systèmes étant à haut risque pour l’éducation :

| Classification des SIA par niveau de risque (Article 6) | Description |

| 🔴Risque inacceptable | Les technologies d’IA présentant un danger critique pour la sécurité, les droits fondamentaux ou les libertés individuelles sont interdites. Cela inclut, par exemple, les systèmes capables d’influencer ou de manipuler le comportement humain au point d’entraver son libre arbitre. |

| 🟠IA à haut risques | Certains systèmes d’IA soumis à des réglementations spécifiques de l’UE en matière de sécurité des produits, ainsi que ceux opérant dans des secteurs sensibles tels que l’éducation et l’emploi, doivent respecter des normes strictes. Les acteurs concernés doivent satisfaire à des exigences détaillées de conformité. |

| 🟡IA à usage général | Les modèles d’IA pouvant être intégrés dans divers systèmes doivent répondre à des obligations particulières, adaptées aux risques qu’ils présentent. |

| 🔵IA à risque limité | Les technologies d’IA, dont le principal enjeu est la transparence, doivent garantir une information adéquate aux utilisateurs. Par exemple, un chatbot doit clairement indiquer qu’il n’est pas humain afin d’éviter toute confusion. |

| 🟢IA à risque minimal | Certains systèmes d’IA ne posent que peu de risques pour que utilisateurs soient autorisés sans contraintes majeures. Cela inclut notamment les outils comme les filtres anti-spam, utilisés pour améliorer l’expérience numérique sans impact significatif sur la sécurité ou les droits individuels. |

Après avoir pris en compte ces éléments, vous pouvez documenter les objectifs et périmètre du projet afin de rendre conforme l’analyse des besoin à la phase de validation.

Trois exemples pour illustré cette étape

Grammarly (Transparence par la Gestion des données utilisateur)

Objectifs du système :

- Offrir une assistance à l’écriture personnalisée.

- Permettre à l’utilisateur de contrôler l’usage de ses données.

- Renforcer la confiance par une transparence explicite.

Périmètre :

- Niveau d’automatisation : système fondé sur la connaissance linguistique et l’apprentissage automatique.

- Degré d’autonomie : fonctionne sans supervision humaine constante.

- Capacité d’auto-apprentissage : système évolutif basé sur les retours utilisateurs.

- Clarté des objectifs : explicites et affichés dans l’interface.

- Capacité d’inférence : génère des suggestions à partir du texte saisi.

- Typologie des résultats : recommandations linguistiques, générations de contenus (corrections et reformulations de texte).

- Interaction avec l’environnement : influence passive sur l’environnement numérique car il agit sur les textes produits dans les environnements numérique mais ne modifie pas directement les systèmes ou les flux de données.

- Classification AI Act : 🔵risque limité -> obligation de transparence sur l’usage des données

Salesforce Einstein (Transparence par l’Explication des prédications)

Objectifs du système :

- Fournir des prédictions commerciales.

- Expliquer les facteurs influençant les décisions de l’IA.

- Centraliser les données.

Périmètre :

- Niveau d’automatisation : entre machine automatisée et système basé sur la connaissance.

- Degré d’autonomie : semi-autonome. Certaines tâches sont entièrement automatisées (tâches de routines) mais d’autres nécessitent d’être supervisées.

- Capacité d’auto-apprentissage : système adaptatif selon les données clients.

- Clarté des objectifs : explicites et divisés selon le rôle de l’utilisateur (étudiants et personnel éducatif). Pour les étudiants, il peut planifier les diplômes, générer des compétences, faire des résumés de mentorat. Pour le personnel éducatif, il peut centraliser les données pour avoir une vue complète de chaque étudiant, et automatiser des tâches administratives.

- Capacité d’inférence : génère des prédictions à partir de données comportementales.

- Typologie des résultats : prédications (scores d’engagement, réussite académique), recommandations (mentorat, parcours de diplôme), contenus (résumés, messages personnalisés), décisions automatisées (gestion des admissions, alerte, tâches).

- Interaction avec l’environnement : influence active sur les environnements numériques car ils interagissent avec les CRM, les systèmes d’information étudiants, les plateformes de communication. Ils peuvent déclencher des actions, envoyer des messages, modifier des données.

- Classification AI Act : 🟠haut risque car il répond à 3 des objectifs d’un système d’IA à haut risque (admission et affectation, évaluation des apprentissages, détermination du niveau éducatif) -> exigences renforcées en matière de traçabilité et de supervision.

Turnitin (Transparence par la Détection de contenu généré par IA)

Objectifs du système :

- Identifier les contenus générés par IA dans les travaux étudiants.

- Préserver l’intégrité académique.

- Fournir des résultats interprétables aux enseignants.

Périmètre :

- Niveau d’automatisation : système automatisé basé sur des modèles d’analyse textuelle et basé sur la connaissance.

- Degré d’autonomie : génère des résultats sans intervention humaine directe constante. D’un côté, l’assistant IA fonctionne de manière autonome pour analyser les textes soumis, détecter les comportements suspects et fournir des rapports sans intervention humaine directe. D’un autre, l’utilisateur final peut poser des questions ou faire des demandes dans la boîte de discussion ou utiliser des invites prédéfinies.

- Capacité d’auto-apprentissage : aucune information n’a pu être collecté sur ce critère.

- Clarté des objectifs : explicites (intégrité académique) et implicites (développer la pensée critique).

- Capacité d’inférence : analyse de style, structure, probabilité de génération.

- Typologie des résultats : prédictions (détection de contenus généré par IA), recommandations (feedback pédagogique), décisions automatisées (signalement de plagiat ou d’usage d’IA).

- Interaction avec l’environnement : influence active sur les environnements numériques. Il est intégré aux LMS (Learning Management Systems) et interagit avec les plateformes de soumission, et influence les pratiques d’évaluation.

- Classification AI Act : 🟠haut risque car il répond à 2 objectifs d’un système d’IA à haut risque (évaluation des apprentissages, surveillance des examens) -> exigences renforcées en matière de traçabilité et de supervision.

Les exigences du système et validation

La définition des exigences du système permet de formaliser de manière claire, structurée et traçable les attentes fonctionnelles et non fonctionnelles du système d’IA. Elle intègre également des critères de vérification explicites, afin de démontrer la mise en œuvre des exigences, ainsi que leur conformité éthique et réglementaire.

L’intégration du principe de transparence peut s’appuyer sur le croisement des résultats issus du questionnement sur la transparence systémique avec d’autres principes clés de conception éthique, tels que :

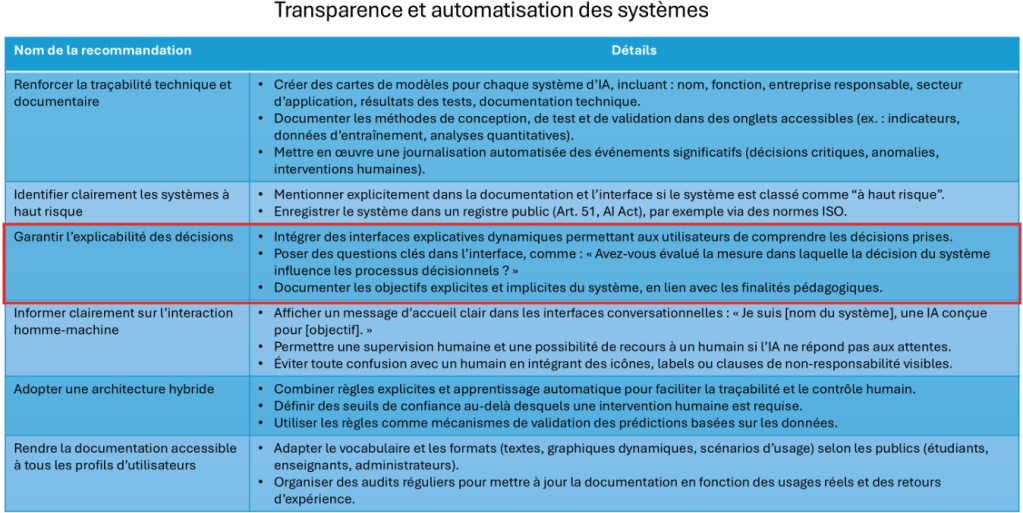

Avant de poursuivre, nous vous mettons à disposition le tableau de bord des recommandations :

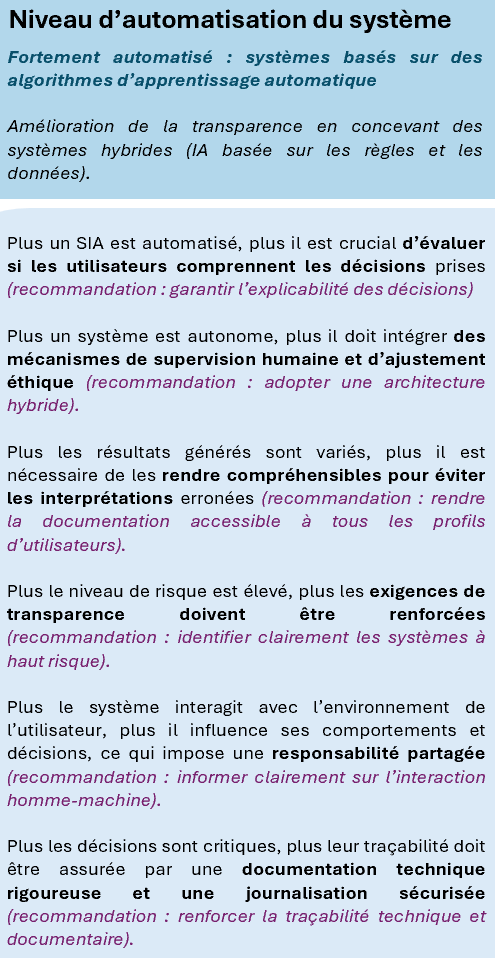

Exemple relatif au premier questionnement : le niveau d’automatisation du système.

Si votre système présente un niveau élevé d’automatisation, il peut être pertinent d’envisager une conception hybride, combinant processus automatiques dans un système expert comme l’a fait l’entreprise Grammarly.

Cela facilite la justification des objectifs, tout en renforçant l’ancrage du principe d’interprétabilité, en rendant les mécanismes plus compréhensibles pour les utilisateurs.

Cette automatisation devra également être prise en compte dans vos exigences, en intégrant les recommandations spécifiques disponibles dans notre tableau de bord :

Enfin, en veillant à ce que les objectifs du systèmes soient formulés de manière explicite, vous facilitez la phase de validation de votre projet et renforcez la transparence dès les premières étapes du cycle de vie.

La conception générale et intégration

La phase de conception générale vise à structurer l’architecture globale de votre système d’IA. Elle permet d’anticiper les besoins d’assemblage, de garantir la cohérence entre les composants, et d’intégrer des critères de robustesse, de modularité et d’évolutivité. Cette conception doit préparer une intégration maîtrisée, documentée et économiquement justifiable.

Pour chaque recommandation issue du tableau de bord (niveau d’automatisation, capacité d’inférence, etc.), posez-vous la question suivante :

- Qu’est-ce que cela implique dans la conception de mon système ?

En reprenant notre premier questionnement, il faudra réfléchir à :

- Comment expliquer les résultats fournis aux utilisateurs ?

- Comment l’interface permettra de faire comprendre les choix du système ?

Exemple : Salesforce et les cartes de modèles

L’entreprise Salesforce a intégré dans sa plateforme Einstein Discovery un outil appelé « model cards« . Il utilise ses cartes de modèles pour évaluer l’impact des décisions sur les processus interne. Cela permet d’avoir un outil complet et structurant, capable d’accompagner les utilisateurs dans leur compréhension des prédictions fournis par le système.

Ces cartes agissent comme une fiche explicatives du comportement du modèle. Elles incluent :

- Les données utilisées pour l’entraînement,

- Les hypothèses de conception,

- Les limites connues,

- Le public cible,

- Les statistiques de performance du modèle.

Concrètement, intégrer ce type de carte dans votre propre système revient à offrir aux utilisateurs une vue pédagogique des mécanismes derrière les résultats qu’ils voient à l’écran.

Pour votre projet, ce type de carte revient ) :

- Documenter les choix de conception dès le départ,

- Rendre visibles les objectifs et les limites du système,

- Renforcer la confiance des utilisateurs, même non-experts.

C’est une manière concrète de transformer une exigence abstraite (comme « rendre le système explicable ») en élément tangible de votre architecture.

La conception détaillée et test utilitaire

La phase de conception détaillée consiste à spécifier techniquement chaque composants afin de garantir leur traçabilité, leur transparence et leur capacité à être testés de façon isolée.

Chaque composant doit être conçu de manière à faciliter l’évaluation lors des tests unitaires, en intégrants des critères tels que (basé sur notre exemple de carte de modèle) :

- La lisibilité du code ou de la logique sous-jacente.

- La compréhension du rôle de chaque composants dans l’ensemble du système.

- L’identification rapide des erreurs ou de comportements inattendus.

À cette phase, il est important de réfléchir aux impacts potentiels de chaque composant, qu’ils soient :

- Positifs (bénéfices pour les utilisateurs),

- Négatifs (risque éthiques),

- Ou indirects (effets non intentionnels).

Ces impacts doivent être documentés, puis vérifiés à l’aide de scénarios de test.

Exemple : les cartes de modèles de Salesforce

Nous venons de voir que dans sa plateforme Einstein Discovery, Salesforce utilise des cartes de modèles pour documenter chaque modèle prédictif. Ces fiches incluent : les données d’entraînement, les hypothèses de conception, les limites connues, etc.

Elles sont utiles car elles renforcent l’interprétabilité et peuvent servir de référence pour concevoir des modules plus transparents et testables.

Croiser conception technique et analyse du besoin

A cette étape, il est pertinent de croiser les choix techniques avec les questionnements issus de l’analyse du besoin. Par exemple, si le système est fortement automatisé, il devient essentiel de :

- Formuler des objectifs explicites dès la conception.

- Choisir des modèles interprétables : utiliser des modèles simples ou fournir des mécanismes explicites (comme les cartes de modèles) garantit que les décisions ne restent pas des « boîtes noires ».

- Adapter les explications selon les niveaux de technicité du public (développeurs, enseignants, utilisateurs finaux, institutions) augmente l’accessibilité cognitive du système. Cela favorise l’appropriation par les parties prenantes et simplifie les audits.

La prise en compte de l’interprétabilité dès la conception permet d’éviter de devoir rétrofiter la transparence après coup. Il sera possible de tester, dès les premiers prototypes, si les modules respectent les attentes en matière d’interprétation et de justification.

Le développement / Réalisation / Implémentation

Cette phase vise à construire le système conformément aux spécifications techniques et fonctionnelles définies en conception, en garantissant :

- La qualité du code,

- La robustesse des composants,

- La prise en compte des exigences de traçabilité, de sécurité et d’éthique.

Au delà de l’aspect technique, c’est à ce moment que la transparence prend forme concrètement. Vous vous posez peut-être la question : comment intégrer la transparence pendant le développement ? Voici quelques éléments essentiels :

- Mettre en place une journalisation systématique des évolutions, incluant l’historique des modifications de code, des modèles et des paramètres déployés, de manière à permettre un audit technique complet.

- Assurer une traçabilité des résultats produits par le système à chaque étape du traitement, avec enregistrement des entrées, décisions intermédiaires et sorties, afin de justifier les actions du système.

- Intégrer des mécanismes de contrôle stricts sur les données personnelles, incluant la minimisation des données, le suivi des accès, et le respect des droits des personnes (accès, opposition, suppression).

- Fournir une documentation continue pendant le développement, incluant les arbitrages techniques, les tests réalisés et les dépendances critiques, pour assurer la continuité avec les futures phases de test, de mise en service et de supervision.

Et si votre système est à haut risque ?

Conformément à l’AI Act, un système à haut risque doit répondre à des exigences renforcées :

En intégrant la traçabilité dès le développement, vous facilitez :

- La compréhension des choix techniques,

- La justification des décisions,

- La proposition d’amélioration concrètes, compréhensibles par toutes les parties prenantes.

En ayant à l’esprit la traçabilité, il sera plus facile de tirer des conclusions et proposer des améliorations concrètes compréhensible par toutes les parties prenantes.

Exemple : Turnitin et la transparence dans la détection de contenu généré par IA

Turnitin est largement utilisé dans les établissements éducatifs, il a intégré un outil de détection de contenu généré par IA dans sa plateforme.

Ce système, potentiellement classé à haut risque selon l’AI Act car il est dans le secteur éducatif et il a un impact sur l’évaluation, et la mis en œuvre plusieurs mécanismes de transparence dès la phase de développement :

- Journalisation des évolutions : historique des mises à jour de l’algorithme de détection ainsi que la documentation des changements de seuils de détection ou de critères d’analyse.

- Traçabilité des résultats : chaque rapport de détection inclut les passages suspects, le score de probabilité, les critères utilisés pour l’analyse. Ces éléments sont enregistrés et accessibles pour vérification par les enseignants.

- Contrôle des données personnelles : respect du RGPD avec des travaux analysés sans être utilisé pour entraîner les modèles sans consentement. Les utilisateurs peuvent demander la suppression de leurs données ou le faire en supprimant leur compte.

- Documentation continue : guides à destination des enseignants expliquant le fonctionnement de l’outil, ses limites, les bonnes pratiques d’interprétation des résultats.

Turnitin montre qu’un système à haut risque peut intégrer la transparence lors du développement, en :

- Documentant les choix techniques,

- Rendant les résultats interprétables,

- Respectant les droits des utilisateurs,

- Facilitant l’audit par les établissements.