Dans un contexte où les systèmes d’intelligence artificielle (IA) s’intègrent de plus en plus dans les environnements éducatifs, la transparence ne peut plus être une option. C’est d’ailleurs le souhait de l’union européenne en mettant en vigueur en 2024 une nouvelle réglementation sur l’IA.

Qu’est ce que le principe de transparence : il désigne la capacité d’un système à rendre compréhensibles ses mécanismes de fonctionnement, ses finalités, ses limites et ses impacts pour l’ensemble des parties prenantes (Weiser, 2020).

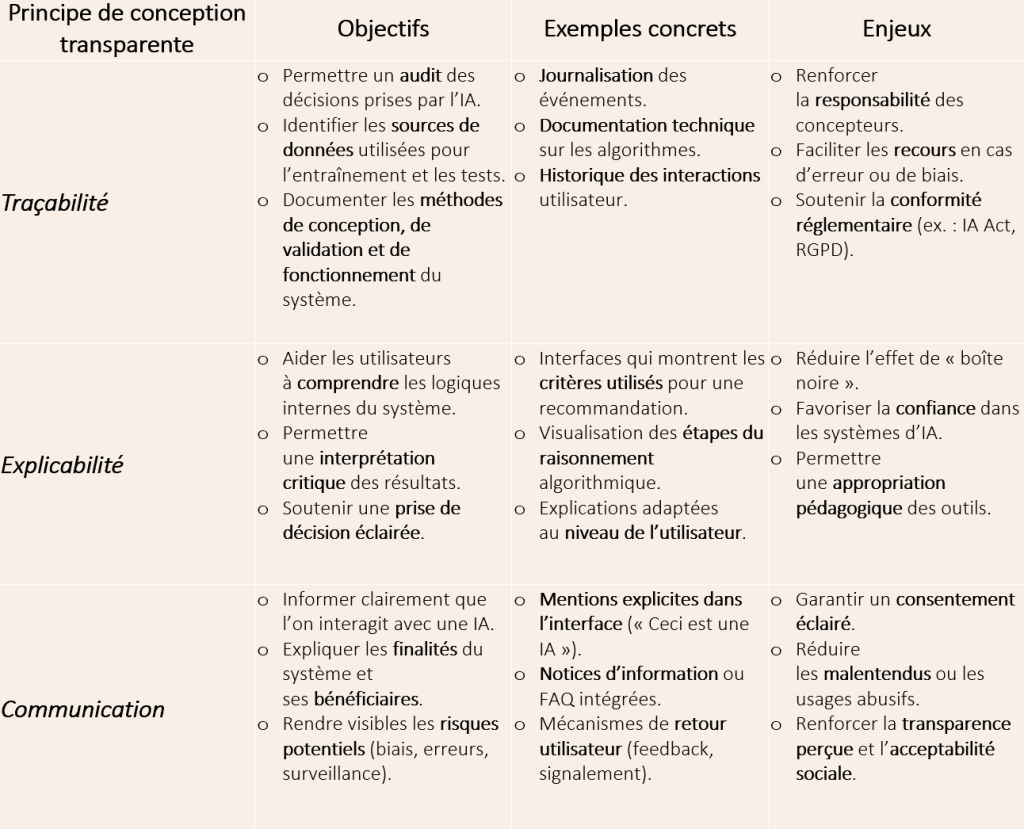

L’outil ALTAI (Assessment List for Trustworthy Artificial Intelligence), développé par la Commission européenne, propose de décliner la transparence en trois dimensions :

- La traçabilité : la capacité à reconstituer le cheminement d’une décision ou d’un résultat produit par un système d’IA, en identifiant les données, les règles ou les algorithmes qui y ont contribué.

- L’explicabilité (compréhension des résultats) : la capacité d’un système d’IA à fournir des explications compréhensibles sur la manière dont il a produit un résultat ou pris une décision.

- La communication (information claire et adaptée aux utilisateurs) : l’ensemble des informations transmises aux utilisateurs sur le fonctionnement, les objectifs, les limites et les risques du système d’IA.

Au travers de cet outil, nous pouvons constater que la transparence ne se limite pas à l’accès au code source : elle implique une explicabilité des processus décisionnels, une traçabilité des données et une communication claire adaptée aux différents profils d’utilisateurs.

Dans le secteur éducatif, où les décisions algorithmiques peuvent influencer l’orientation, l’évaluation ou l’accès à des ressources, la transparence devient un levier de confiance, d’équité et de responsabilité.

Transparence et réglementation

Dans le domaine juridique, Bourcier et al. (2018) rappellent que la transparence algorithmique repose sur deux piliers complémentaires :

- L’accessibilité : la possibilité d’accéder aux règles ou au code source.

- L’intelligibilité : la capacité à comprendre les logiques internes du système.

Cette approche est renforcée par les exigences du Règlement général sur la protection des données (RGPD), qui introduit le droit à une explication des décisions automatisées (Wachter, 2017), et par l’IA Act de l’union européen (2024), qui impose aux systèmes d’IA à haut risque des obligations strictes en matière de journalisation, de documentation technique et de supervision humaine.

Transparence et impact éthique

Sur le plan éthique, l’approche « ethics by design » propose d’intégrer les valeurs humaines dès la phase de conception des systèmes (Friedman et al., 2006 ; Verbeek, 2011 ; Spiekermann, 2015).

La transparence y est envisagée comme une médiation morale : elle permet aux utilisateurs de comprendre les décisions prises par l’IA, de les contester si nécessaire, et de conserver leur autonomie dans l’interaction avec la technologie.

Cette approche est particulièrement pertinente dans l’éducation, où les décisions algorithmiques peuvent avoir un impact direct sur les parcours des apprenants (Miao et Holmes, 2024).

Transparence et conception orientée utilisateur

La transparence interactionnelle, telle que développée par Kaadoud (2022) et Weiser (2020), insiste sur le rôle des interfaces utilisateurs dans la perception de la transparence.

La transparence ne se décrète pas uniquement par la technique ou la loi, mais se construit dans l’expérience d’usage :

- Une interface claire,

- Des explications accessibles,

- Des options de personnalisation,

- Des retours pédagogiques.

Prendre en compte l’expérience des utilisateurs permet de renforcer leur compréhension et leur confiance envers le produit d’IA éducatif

Opérationnalisation de la transparence

La transparence dans les systèmes d’IA ne peut être réduite à une exigence technique ou réglementaire : elle constitue un enjeu éthique, pédagogique et sociétal. Elle conditionne la confiance des utilisateurs, la légitimité des décisions automatisées et la conformité aux droits fondamentaux.

Références bibliographiques

- Weiser, S. (2020). Requirements of Trustworthy AI. Commission européenne. https://ec.europa.eu/futurium/en/ai-alliance-consultation/guidelines/1.html#Transparency

- Bourcier, D., et al. (2018). Transparence et intelligibilité des algorithmes. Rapport sur les enjeux juridiques de l’IA.

- Wachter, S., Mittelstadt, B., & Floridi, L. (2017). Counterfactual Explanations without Opening the Black Box: Automated Decisions and the GDPR. ArXiv. https://doi.org/10.48550/arXiv.1711.00399

- Friedman, B., Kahn, P., & Borning, A. (2006). Value Sensitive Design and Information Systems. In P. Zhang & D. Galletta (Eds.), Human-Computer Interaction and Management Information Systems: Foundations. M.E. Sharpe.

- Verbeek, P.P. (2011). Moralizing Technology: Understanding and Designing the Morality of Things. University of Chicago Press.

- Spiekermann, S. (2015). Ethical IT Innovation: A Value-Based System Design Approach. Routledge.

- Kaadoud, I. C. (2022). Faire confiance à l’IA ? L’intelligence artificielle pour et par les enseignants. INRIA Learning Lab.

- Miao, F., & Holmes, W. (2024). Orientations pour l’intelligence artificielle générative dans l’éducation et la recherche. UNESCO.

- Commission européenne (2020). Assessment List for Trustworthy Artificial Intelligence (ALTAI).